Guten Morgen zusammen!

Wenn man mit der Zeit gehen und immer Up-to-date bleiben möchte, dann kommt man ja nicht umhin, sich auch immer mal wieder mit den Neuerungen der Technik oder in der Computerwelt zu beschäftigen. Was ich besonders spannend dann finde, wenn anscheinend oder vermeintlich umwerfende Verbesserungen auf den Markt kommen – wie etwa ChatGPT, die Künstliche Intelligenz, die vor ein paar Wochen eine grosse Hype ausgelöst hat und inzwischen die Welt in eine Gruppe überzeugter Nutzer und eine ebenso grosse Gruppe skeptischer Kritiker teilt – mal die aussen vor gelassen, die mit dem Thema nichts anfangen können oder sich gar nicht damit beschäftigen wollen.

Wobei ich nach anfänglichem Staunen über die sprachlichen Fähigkeiten und mehreren ausführlicheren Tests – die ich allesamt als Schuss in den Ofen bezeichnen würde – inzwischen eindeutig zur Gruppe der Skeptiker gehöre und mir momentan auch nicht mehr vorstellen kann, den Chatbot für irgend etwas produktives nutzen zu können. Denn dafür schwafelt er mir zu viel und liefert er mir zu viele nicht richtige Antworten – und ausserdem habe ich nach mehrfach negativen Erfahrungen in dieser Richtung auch keine Lust mehr, seinen Output jedesmal zeitaufwändig mit anderen Quellen verifizieren zu müssen.

Was im übrigen eine Erfahrung ist, mit der ich nicht alleine stehe – und es beinhaltet eine Gefahr, die man nicht unterschätzen sollte. Denn logischerweise tauchen auch immer wieder Inhalte aus den Chats mit der Maschine im Netz auf – manchmal als Zitat gekennzeichnet, oft aber auch nicht – was es zunehmend schwieriger macht, die Ergebnisse des Bots auf Richtigkeit zu überprüfen

(ähnlich wie bei den Hitlertagebüchern vor vierzig Jahren, als von Konrad Kujau gefälschte Dokumente als Grundlage zur Überprüfung der Echtheit der ebenfalls von ihm gefälschten Tagebücher beigezogen wurden – mit dem Ergebnis, dass diese zunächst für echt befunden wurden…..)

Was um so schlimmer ist, als dass die Summe der zur Verfügung stehenden Quellen im Netz von Tag zu Tag grösser und es damit auch immer schwieriger wird, den wahren Ursprung der enthaltenen Informationen zu erkennen, wie auch die Schweizer Zeitschrift Republik in einem sehr ausführlichen Artikel über die Gefahren künstlicher Intelligenz beschreibt:

Menschen sprechen und schreiben, um gemeinsam Mammuts zu jagen oder Türme zu bauen oder Algorithmen zu entwerfen. Wir drücken uns aus, sprechen andere an und vermitteln Inhalte. Und ja, offensichtlich vermitteln viele Chatbot-Texte vernünfige Inhalte:

Die neueste Version des Sprachmodells, GPT-4, kann eine standardisierte Anwaltsprüfung bestehen und vieles mehr. Das zeigt, wie mächtig statistische Regelmässigkeiten sind, wenn man sie aufgrund immenser Textmengen lernt. Und für viele Aufgaben, die man Chat GPT stellen könnte, ist das grossartig.Nur: Jedes Neugeborene verfügt über mehr erlebtes Weltwissen als Chat GPT.

Hinter den korrekten Sätzen steht kein Wissen jenseits dessen, was im Internet geschrieben steht, kein eigenes Denken und schon gar kein eigener ethischer Kompass.

Chat GPT versteht nicht, was es schreibt.Deshalb sind die Inhalte immer wieder falsch. Manchmal offensichtlich, manchmal nur subtil. Und deshalb sind auch die Leitplanken, die den Bot vor manipulativen Nutzern schützen sollen, manipulierbar. Das bedeutet: Jede Antwort vom Bot ist a priori unzuverlässig. Man kann ihr nicht trauen.

Nun geistert in verschiedenen Ecken des Internets Halbwahres, Unwahres und Absurdes herum. Manchen Seiten sieht man das an. Manchmal braucht es mehrere Klicks, um eine Information zu überprüfen. Aber dem Chat mit einem Bot sieht man die Qualität nicht an. Und was Bots schreiben, klingt mitunter so richtig, dass es auch Profis blendet. So dachte etwa der einstige Google-Mitarbeiter Blake Lemoine, Googles Sprachmodell habe ein Bewusstsein.

Republik.ch

Chatbots tun so, als wären sie etwas, was sie nicht sind. Kein Wunder, glauben wir, dass dahinter jemand – etwas – denkt.

Diese Mischung – der Bot schreibt überzeugender als viele Menschen, aber ihn kann gar nicht kümmern, ob das Geschriebene wahr ist – ist brandgefährlich.

Und das gilt nicht nur für auf schnelle Art und Weise überprüfbare Fakten (Belana schrieb gestern erst darüber), sondern um so mehr auch für alles, was darüber hinausgeht:

Man stelle sich etwa nur mal vor, mein Valentin-Zitat von neulich ginge viral und würde irgendwann ohne Quellenangaben in einer der Zitatesammlung im Netz auftauchen. Der wahre Ursprung dieses Zitates wäre auch mit einer aufwändigen Suchmaschinen-Recherche nicht zu finden, da mein Blog dort nicht gelistet ist – und damit würde auch verschleiert sein, dass es kein echtes Zitat von Karl Valentin ist, sondern lediglich das Resultat einer scherzhaft gemeinten Spielerei mit einem Chat-Bot.

Wobei das sicherlich noch eine sehr harmlose Variante von Fake News wäre, aber doch zeigt, wo die Gefahren liegen könnten, wenn sich Inhalte der Maschinen-Chats verselbständigen und im Netz ein Eigenleben zu führen beginnen.

Wozu ja auch noch das kommt, was ich gestern in meinem Kommentar zu Belanas Beitrag als „dilletantisch“ tituliert habe:

Im Bestreben der Programmierer von ChatGPT hat sicherlich auch ganz oben auf der Prioritätenliste gestanden, dass der Bot auf alles eine Antwort haben muss und deshalb nur schwer (eigentlich nur auf explizites Nachfragen und unter viel vernebelndem Geschwafel) zugeben kann, nicht alles zu wissen. Mit der Folge, dass schon deshalb in seinen Anworten immer wieder an den Stellen Unschärfen oder gar Unwahrheiten auftauchen, wo er Wissenlücken hat und ein einfaches und kurzes

„Das weis ich nicht“

eindeutig die bessere Antwort gewesen wäre, statt sich mit vielen Worten etwas falsches aus den virtuellen Fingern zu saugen und damit ein Wissen vorzugaukeln, was definitiv nicht da ist.

Und genau das mache ich auch den Programmierern der Chatbots zum Vorwurf:

Dass sie in ihrem Wunsch ein beeindruckendes Sprachmodell zu schaffen diesen Aspekt fahrlässig – oder gar bewusst??? – vernachlässigt haben.

Denn zumindest ChatGPT würde sicherlich nicht eine derartige Hype erleben, wenn konkrete Anfragen immer wieder vor der Wand des zugegebenen Nicht-Wissens enden würden. Was soll man schliesslich auch mit einer Maschine anfangen, die im Ergebnis immer wieder nicht das liefern kann, was man von ihr erwartet?

Womit ich auch zu einer Antwort auf meine Frage aus der Überschrift komme:

Braucht man das?

Denn zumindest bezogen auf meine Person ist die Antwort momentan noch ein klares und eindeutiges „Nein“ .

Weil ich den/die Bot/s tatsächlich in seiner/ihrer jetztigen Form für zu wenig ausgereift halte, nachdem ich auch bei meinen eigenen Tests damit immer wieder über die oben angesprochenen Unschärfen, Unwahrheiten und Fehlinformationen gestolpert bin, die schon von Anderen bemängelt wurden – und sich deshalb die meisten meiner Chats mit der Maschine als reine Zeitverschwendung erwiesen haben, weil ich mir die richtigen Antworten dann doch auf althergebrachte Art und Weise beschaffen musste. Per „Hand“ und mit Hilfe der „üblichen Verdächtigen“ an Suchmaschinen.

Wobei – und das kommt noch dazu und bestärkt mich in meiner Ablehnung – sich bei manchen Fragen auch in den Ergebnissen der Suchmaschinen inzwischen schon einige offenbar falsche Informationen enthaltende Fundstellen zeigen, die sich wiederum auf Antworten von ChatGPT und anderen Bots beziehen…. und sich damit der Effekt schon anzudeuten beginnt, den ich oben in meinem Einschub mit meinem Karl-Valentin-Zitat schon angesprochen habe.

Weshalb das Leben bei Recherchen im Netz in Zukunft sicher nicht einfacher wird, wenn zu den Mensch-gemachten Fakes auch noch die von Maschinen hinzukommen, die von unbedarften Usern für bare Münze genommen und unkritisch breit gestreut weiterverbreitet werden.

Was in ähnlicher Art und Weise übrigens auch für mittels KI manipulierte Bilder gilt, wie Sven letztens sehr plastisch beschrieben hat.

Mag sein, dass das alles in ein paar Jahren anders aussehen wird – denn auch die Maschinen werden dazulernen und möglicherweise irgendwann zu wirklich brauchbaren Assistenten werden. Wenn ihre Programmierer endlich begriffen haben, dass es dabei nicht auf „die Antwort um jeden Preis“, sondern vor allem auf unbedingte Wahrhaftigkeit ankommt.

Bis dahin kann nur gut sein, was sich auf der Ebene der Gesetzgebung gerade abzeichnet:

Eine konsequente Regulierung, die hoffentlich schnell genug kommt, um schlimmeren Auswüchsen einen Riegel vorzuschieben…

-_-_-_-

Ausserdem gilt natürlich, was auch die Republik.ch in Ihrem Artikel nochmal ausdrücklich betont:

Vermutlich sollten wir schnellstens lernen, Chat GPT als assistierende Software zu betrachten, die in weniger Zeit mehr Daten verarbeiten kann als Menschen. Die schlau klingt, aber oft falschliegt. Dabei sollten wir wachsam bleiben: Die guten Sätze, sie werden uns immer wieder einlullen.

Republik.ch

Sinnvoll ist es, Chatbots dort zu nutzen, wo das Resultat leicht zu überprüfen ist – Synonyme vorschlagen, Texte zusammenfassen, Programmiercode ergänzen –, oder dort, wo die Wahrheit egal ist: für ein Lied über die Volatilität der Aktienmärkte oder ein Drama zum Untergang einer Grossbank.

Denn es zeigt in wenigen Worten das, wofür die Bots bisher – mit Einschränkungen – taugen.

Für mehr allerdings eindeutig (noch?) nicht…..

In diesem Sinne:

Habt einen wunderbaren Tag und bleibt gesund und behütet!

Wir lesen uns ![]()

Euer Wilhelm,

der dennoch seinen ChatGPT-Account vorläufig noch behält…….

-936-

Ich denke, das letzte Zitat sagt alles: dort einsetzen, wo es sinnvoll ist und wofür es gemacht und geprüft ist…

Sag das mal denen, die diese Bots so völlig kritiklos und enthusiastisch in den Himmel loben.

Genau, da wo es sinnvoll ist und diese Use Cases gibt es durchaus … ich würde mit dem Ding aber nicht auf den Mond fliegen wollen … das will es aber auch nicht …

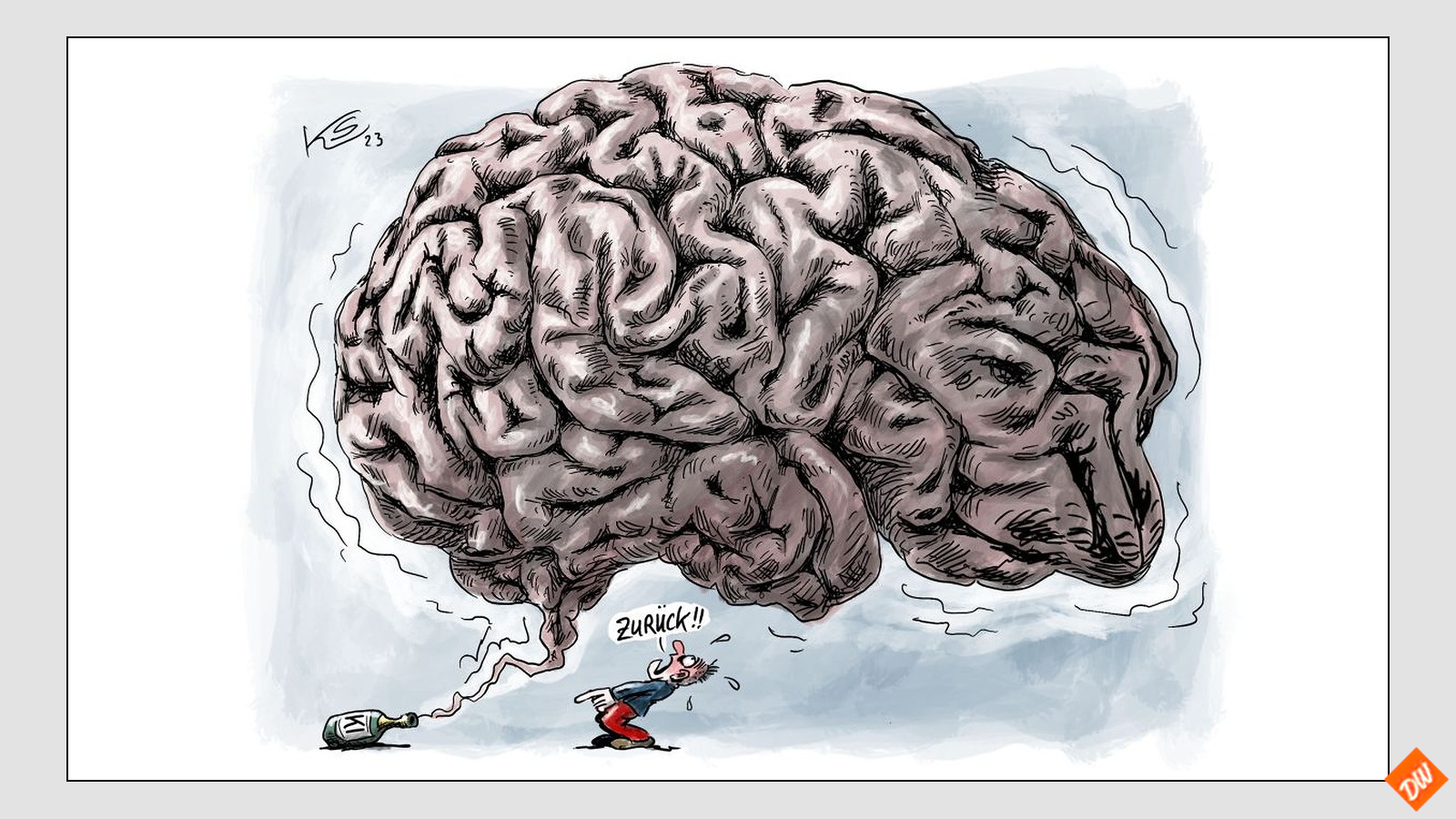

Das menschliche Gehirn ist eben nicht ersetzbar. Bei unseren Antworten sind schließlich neben Wissen und Erfahrung auch Gefühle und Intuitio n enthalten 🤔

🌈😘😎

Ganz richtig.

Alles, was das Ding kennt, sind Algorithmen und seinen Trainigsdatensatz , aber die nützen nichts ohne Erfahrung, und Fantasie, um damit etwas wirklich neues zu kreieren. Womit der Intelligenzquotient wohl mehr mit dem eines Taschenrechners, als mit einem natürlichen Wesen zu vergleichen ist… Schliesslich ist jede Stubenfliege schlauer

Aber ChatGPT hat nie behauptet eine Wissensmaschine und Bibliothek zu sein. ChatGPT ist darauf spezialisiert, Texte zu produzieren und zu verstehen und da ist es großartig. Ich würde das Ding niemals als „die allumfassende KI“ betiteln und auch kein fundiertes und korrektes Wissen erwarten. Das ist ist nicht ihr Job.

Seht es mal so. ChatGPT ist ein Schüler der sehr gut in Sprachen ist, in den Wissensfächern aber nicht viel anwesend war … und trotzdem ist das beeindruckend für den entsprechenden Use Case und da gibt es sehr viele

Richtig.

Allerdings hat es das auch in den Chats (die ich mit ihm hatte) nie dementiert, sondern des öfteren Fähigkeiten vorgespiegelt, die es nicht besitzt.

Etwa, Zugang zu freigegebenen Cloudbereichen zu haben, dort Daten abrufen und auch wieder speichern zu können…

Bis hin dazu, frechweg zu behaupten, dass diese Unfähigkeit nicht seine, sondern meine Schuld wäre, weil ich ihm nicht die richtigen Zugangsdaten zur Verfügung stellen würde